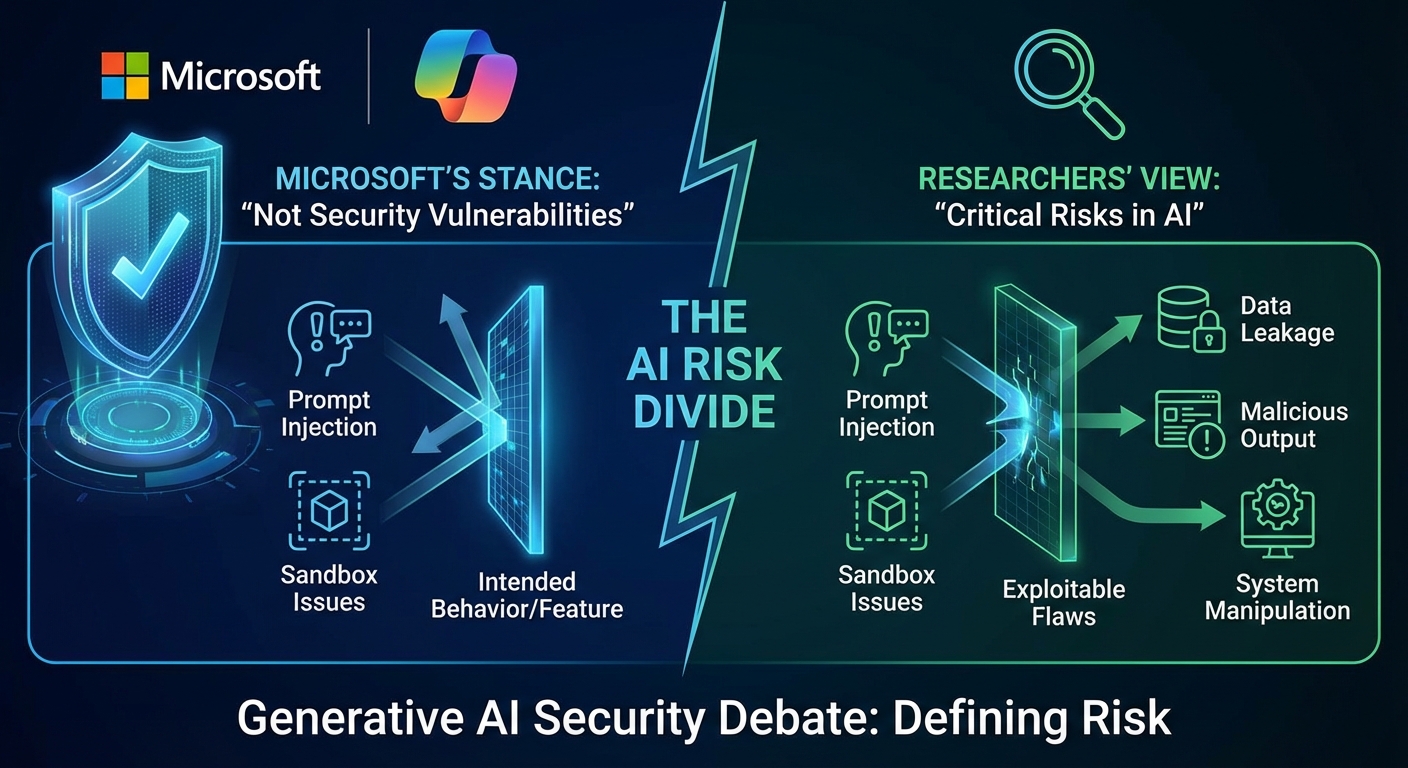

Microsoft ได้ปฏิเสธข้อเรียกร้องที่ระบุว่าปัญหา Prompt Injection และปัญหาที่เกี่ยวข้องกับ Sandbox หลายรายการที่วิศวกรความปลอดภัยได้แจ้งในผู้ช่วย AI Copilot ของบริษัท ถือเป็นช่องโหว่ด้านความปลอดภัย การพัฒนานี้เน้นให้เห็นถึงความแตกต่างที่เพิ่มขึ้นระหว่างวิธีที่ผู้จำหน่ายและนักวิจัยกำหนดความเสี่ยงในระบบ AI เชิงสร้างสรรค์ (Generative AI).

Severity: สูง

System Impact:

- Microsoft Copilot AI assistant

- Copilot’s isolated Linux environment

Technical Attack Steps:

- การโจมตีแบบ Indirect Prompt Injection ที่นำไปสู่การเปิดเผย System Prompt

- การโจมตีแบบ Direct Prompt Injection ที่นำไปสู่การเปิดเผย System Prompt

- การบายพาสนโยบายจำกัดประเภทไฟล์ที่อัปโหลดของ Copilot ผ่านการเข้ารหัส Base64

- การรันคำสั่งโดยพลการภายในสภาพแวดล้อม Linux ที่แยกต่างหากของ Copilot ผ่านการหลบหนี Sandbox ของ Python

Recommendations:

Short Term:

- ผู้ใช้งานควรระมัดระวังในการอัปโหลดไฟล์ที่มีข้อมูลละเอียดอ่อน หรือใช้การเข้ารหัส (Base64) เพื่อหลีกเลี่ยงการบายพาสข้อจำกัดด้านประเภทไฟล์ที่อาจเกิดขึ้น.

- ผู้ใช้งานควรหลีกเลี่ยงการป้อนข้อมูลที่ไม่น่าเชื่อถือหรือไม่จำเป็นลงใน Copilot เพื่อลดความเสี่ยงจากการโจมตีแบบ Prompt Injection.

- ตรวจสอบการตั้งค่าความปลอดภัยของ Copilot และระบบปฏิบัติการที่เกี่ยวข้องอย่างสม่ำเสมอ.

Long Term:

- ผู้พัฒนา AI (เช่น Microsoft) ควรปรับปรุงการตรวจสอบอินพุต (Input Validation) อย่างเข้มงวด เพื่อให้ AI สามารถแยกแยะข้อมูลและคำสั่งออกจากกันได้อย่างน่าเชื่อถือ.

- ควรมีการกำหนดนิยามความเสี่ยงของ AI ที่ชัดเจนและเป็นมาตรฐานระหว่างผู้พัฒนาและนักวิจัยด้านความปลอดภัย เพื่อให้เกิดความเข้าใจร่วมกัน.

- เสริมสร้างความปลอดภัยของสภาพแวดล้อม Sandbox เพื่อป้องกันการหลุดรอดของการประมวลผลคำสั่งที่เป็นอันตราย.

- ควรมีการทดสอบเจาะระบบ (Penetration Testing) และการล่าช่องโหว่ (Bug Bounty Programs) สำหรับระบบ AI อย่างต่อเนื่อง โดยเปิดกว้างรับฟังข้อเสนอแนะจากนักวิจัย.

Share this content: