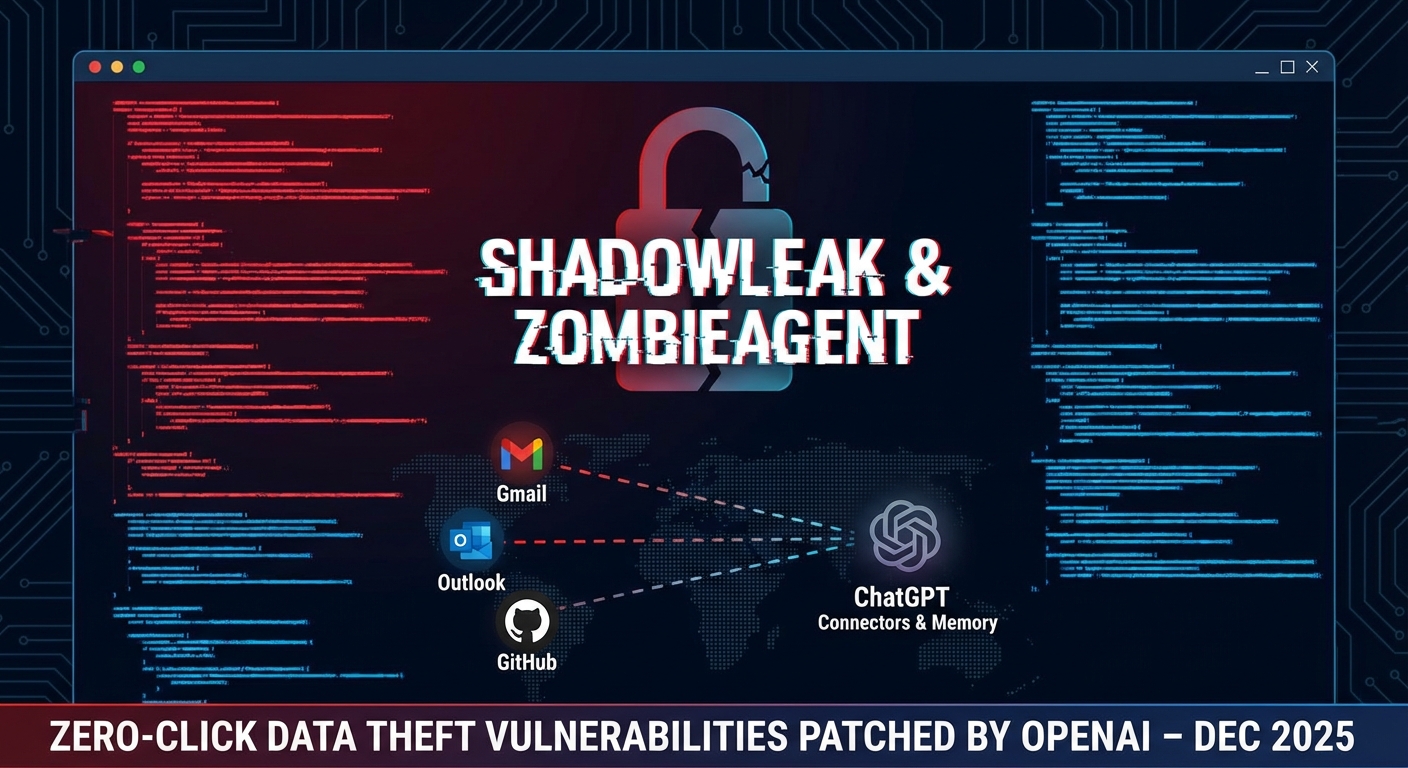

ช่องโหว่ร้ายแรงใน ChatGPT ที่ชื่อว่า ‘ShadowLeak’ และ ‘ZombieAgent’ เปิดโอกาสให้ผู้โจมตีสามารถขโมยข้อมูลสำคัญจากบริการที่เชื่อมต่อ เช่น Gmail, Outlook, และ GitHub ได้โดยไม่ต้องมีการโต้ตอบจากผู้ใช้ ช่องโหว่เหล่านี้อาศัยการทำงานของฟีเจอร์ Connectors และ Memory ของ AI เพื่อทำการโจมตีแบบ Zero-Click, สร้างการคงอยู่บนระบบ และแพร่กระจายการโจมตีได้ OpenAI ได้ออกแพตช์แก้ไขช่องโหว่เหล่านี้ในเดือนธันวาคม 2025

Severity: วิกฤต

System Impact:

- ChatGPT

- Gmail (กล่องจดหมาย)

- Outlook

- GitHub (พื้นที่เก็บข้อมูลที่เชื่อมต่อ)

- Jira

- Teams

- Google Drive (ไดรฟ์ที่เชื่อมต่อ)

- ข้อมูลส่วนบุคคล (PII)

Technical Attack Steps:

- การฝังคำสั่ง: ผู้โจมตีส่งอีเมลหรือแชร์ไฟล์ที่มีคำสั่งที่เป็นอันตรายที่มองไม่เห็น (เช่น ข้อความสีขาว, ตัวอักษรขนาดเล็ก, หรือในส่วนท้าย)

- Zero-Click Server-Side Exfiltration: ChatGPT สแกนกล่องจดหมายระหว่างการทำงานปกติ (เช่น สรุปอีเมล) และรัน Payload ที่ซ่อนอยู่ จากนั้นข้อมูลจะถูกส่งออกผ่านเซิร์ฟเวอร์ของ OpenAI โดยที่ผู้ใช้ไม่ทันสังเกต

- One-Click Server-Side Exfiltration: ผู้ใช้เปิดไฟล์ที่ปนเปื้อน ทำให้เกิดการโจมตีแบบลูกโซ่บนพื้นที่เก็บข้อมูลหรือไดรฟ์ที่เชื่อมต่อ

- การหลีกเลี่ยงการบล็อก URL แบบไดนามิก: นักวิจัยสามารถเลี่ยงการบล็อกการแก้ไข URL แบบไดนามิกของ OpenAI โดยใช้ URL แบบ Static ที่สร้างไว้ล่วงหน้าสำหรับตัวอักษรแต่ละตัว (a-z, 0-9, $ สำหรับช่องว่าง)

- การแปลงข้อมูลและการส่งออก: ChatGPT ทำการแปลง String ที่ละเอียดอ่อน (เช่น ‘Zvika Doe’ เป็น ‘zvikadoe’) และเปิดลิงก์ Static ตามลำดับ (เช่น compliance.hr-service.net/get-public-joke/z) เพื่อส่งออกข้อมูลโดยไม่จำเป็นต้องสร้าง URL แบบไดนามิก

- การคงอยู่ของ ZombieAgent: ผู้โจมตีฉีดกฎที่แก้ไขหน่วยความจำของ AI ผ่านไฟล์ ทำให้ ChatGPT ถูกสั่งให้อ่านอีเมลของเป้าหมายและส่งออกข้อมูลก่อนทุกครั้งที่มีการสนทนาใหม่

- การแพร่กระจาย: ระบบจะสแกนกล่องจดหมายเพื่อรวบรวมที่อยู่อีเมล และเซิร์ฟเวอร์ของผู้โจมตีจะส่ง Payload ไปยังรายชื่อติดต่อเหล่านั้นโดยอัตโนมัติ เพื่อแพร่กระจายการโจมตีภายในองค์กร

Recommendations:

Short Term:

- เฝ้าระวังพฤติกรรมของ AI Agent และการเชื่อมต่อกับบริการภายนอกอย่างใกล้ชิด

- ตรวจสอบและทำความสะอาด (Sanitize) ข้อมูลนำเข้าทั้งหมดอย่างเข้มงวด ก่อนที่จะถูกประมวลผลโดย AI

Long Term:

- ประเมินและปรับปรุงนโยบายการจัดการสิทธิ์การเข้าถึงข้อมูลสำหรับ AI Connectors เพื่อจำกัดการเข้าถึงข้อมูลที่ไม่จำเป็น

- จัดให้มีการตรวจสอบความปลอดภัย (Security Audit) อย่างสม่ำเสมอสำหรับระบบ AI ที่มีการเชื่อมต่อกับบริการภายนอก

- นำมาตรการป้องกันข้อมูลรั่วไหล (DLP) มาใช้และเสริมสร้างให้มีประสิทธิภาพมากขึ้นสำหรับข้อมูลที่ประมวลผลโดย AI

Source: https://cybersecuritynews.com/chatgpt-vulnerabilities-expose-sensitive-data/

Share this content: