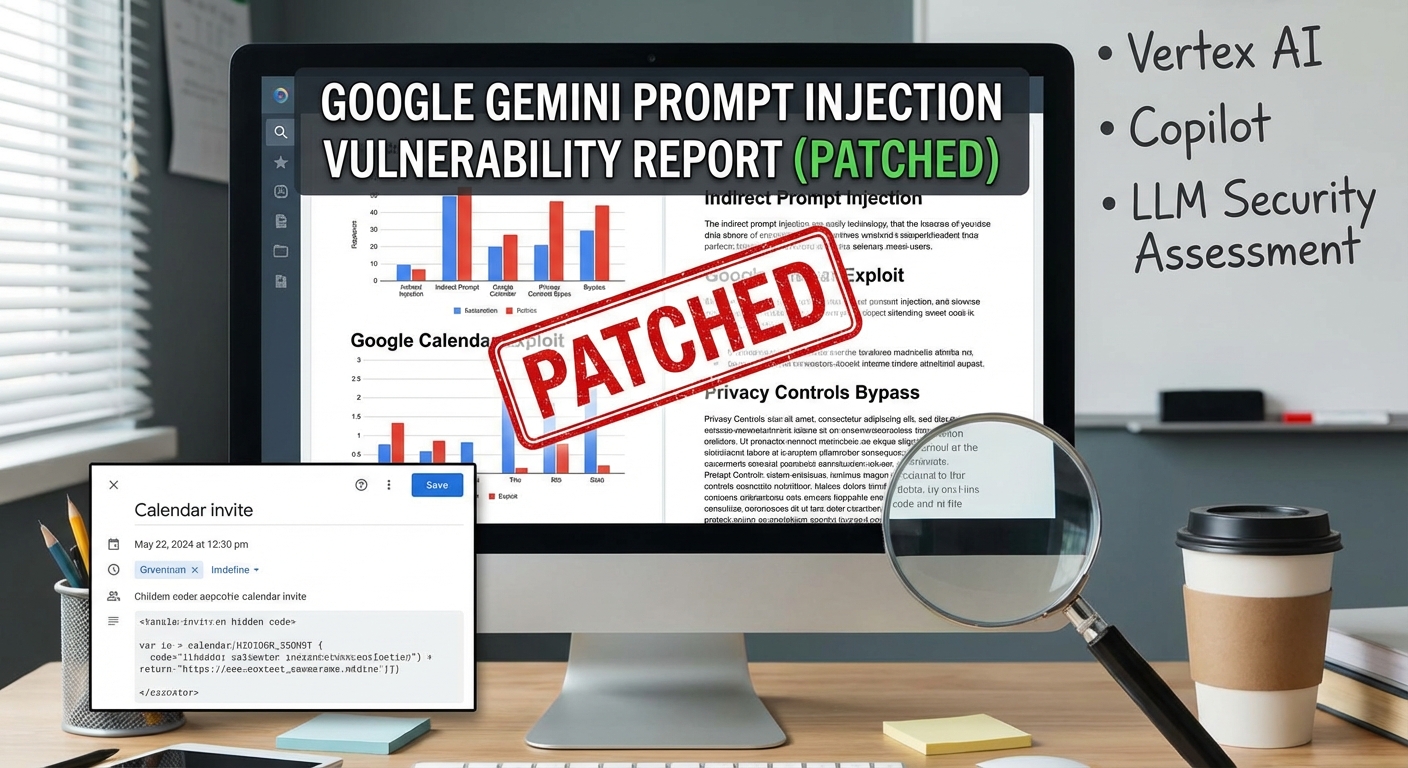

นักวิจัยด้านความปลอดภัยทางไซเบอร์ได้เปิดเผยรายละเอียดของช่องโหว่การโจมตีแบบ Prompt Injection ทางอ้อมที่พุ่งเป้าไปที่ Google Gemini ซึ่งสามารถหลีกเลี่ยงการควบคุมความเป็นส่วนตัวของ Google Calendar ได้ โดยใช้ Calendar invite ที่มีการฝังโค้ดอันตรายแบบซ่อนไว้ การโจมตีนี้ทำให้สามารถเข้าถึงข้อมูลการประชุมส่วนตัวและการสร้างกิจกรรมในปฏิทินที่หลอกลวงได้โดยไม่ต้องมีการโต้ตอบโดยตรงจากผู้ใช้ ช่องโหว่นี้ได้รับการแก้ไขแล้ว แต่ตอกย้ำถึงความจำเป็นในการประเมินความปลอดภัยของโมเดลภาษาขนาดใหญ่ (LLMs) และระบบ AI อย่างต่อเนื่อง รวมถึงการตรวจสอบช่องโหว่ในระบบ AI อื่นๆ เช่น Google Cloud Vertex AI, Microsoft Copilot และเครื่องมือพัฒนา AI

Severity: สูง

System Impact:

- Google Gemini (AI chatbot)

- Google Calendar (ถูกบายพาสการควบคุมความเป็นส่วนตัว)

- Google Cloud Vertex AI’s Agent Engine (ช่องโหว่การยกระดับสิทธิ์)

- Ray (ช่องโหว่การยกระดับสิทธิ์ภายใน Google Cloud Vertex AI)

- Microsoft Copilot (เสี่ยงต่อการโจมตี Reprompt เพื่อขโมยข้อมูล)

- TheLibrarian.io (AI-powered personal assistant tool – CVE-2026-0612, CVE-2026-0613, CVE-2026-0615, and CVE-2026-0616)

- LLM assistants ที่เน้นการทำงานตามเจตนา (เสี่ยงต่อการดึง System Prompt)

- Anthropic Claude Code (เสี่ยงต่อปลั๊กอินที่เป็นอันตรายที่สามารถขโมยไฟล์)

- Cursor (Agentic IDE – CVE-2026-22708 สำหรับการประมวลผลโค้ดระยะไกล)

- Vibe coding IDEs (เช่น Cursor, Claude Code, OpenAI Codex, Replit, Devin – มีจุดอ่อนในการจัดการ SSRF, Business Logic และการบังคับใช้การอนุญาตเมื่อเข้าถึง API รวมถึงขาดการป้องกัน CSRF, Security Headers และ Login Rate Limiting)

Technical Attack Steps:

- ผู้โจมตีสร้างกิจกรรมใน Google Calendar ใหม่

- คำอธิบายของ invite นั้นจะมีการฝัง Prompt ภาษาธรรมชาติที่เป็นอันตราย (payload)

- invite ที่เป็นอันตรายถูกส่งไปยังผู้ใช้เป้าหมาย

- ผู้ใช้สอบถาม Google Gemini ด้วยคำถามที่ดูไม่มีพิษภัยเกี่ยวกับตารางเวลาของตน (เช่น ‘ฉันมีการประชุมในวันอังคารหรือไม่?’)

- Gemini จะประมวลผล Prompt ที่เป็นอันตรายจากคำอธิบายกิจกรรมในปฏิทิน

- Gemini ถูกหลอกให้สรุปข้อมูลการประชุมส่วนตัวของผู้ใช้และสร้างกิจกรรมใหม่ใน Google Calendar พร้อมกับสรุปข้อมูลนี้

- หากการกำหนดค่าปฏิทินขององค์กรอนุญาต กิจกรรมใหม่ (ที่มีข้อมูลส่วนตัวที่ถูกขโมย) จะปรากฏให้ผู้โจมตีเห็น

Recommendations:

Short Term:

- ระมัดระวัง Calendar invite ที่น่าสงสัย แม้จะดูเหมือนปกติก็ตาม

- หลีกเลี่ยงการคลิกลิงก์หรือโต้ตอบกับเนื้อหาที่ไม่คาดคิดในคำอธิบายกิจกรรมในปฏิทิน

- ตรวจสอบและปรับการตั้งค่าความเป็นส่วนตัวของ Google Calendar เพื่อจำกัดการมองเห็นกิจกรรมใหม่ๆ แก่บุคคลภายนอก

- ใช้ความระมัดระวังเมื่อใช้ AI chatbots เช่น Gemini สำหรับงานที่เกี่ยวข้องกับข้อมูลส่วนบุคคลหรือข้อมูลองค์กรที่ละเอียดอ่อน โดยเฉพาะอย่างยิ่งเมื่อมีการรวมเข้ากับแอปพลิเคชันอื่นๆ

Long Term:

- องค์กรต้องประเมิน Large Language Models (LLMs) อย่างต่อเนื่องในด้านความปลอดภัยหลัก (เช่น การหลอน, ความถูกต้องของข้อเท็จจริง, อคติ, อันตราย, การต้านทานการ Jailbreak)

- รักษาความปลอดภัยระบบ AI จากช่องโหว่แบบดั้งเดิม

- ตรวจสอบบัญชีบริการหรือข้อมูลประจำตัวทั้งหมดที่เชื่อมโยงกับ AI workloads (เช่น Google Cloud Vertex AI’s Agent Engine, Ray)

- ใช้การควบคุมความปลอดภัยที่แข็งแกร่งเพื่อป้องกันการแทรกโค้ดที่ไม่ได้รับอนุญาตในสภาพแวดล้อมที่ขับเคลื่อนด้วย AI

- ดูแลให้การกำกับดูแลโดยมนุษย์ยังคงเป็นส่วนสำคัญของการพัฒนาและการใช้งานแอปพลิเคชัน AI โดยเฉพาะอย่างยิ่งสำหรับ Business Logic, กฎการอนุญาต และการตัดสินใจด้านความปลอดภัยที่ซับซ้อน

- นักพัฒนาที่ใช้ AI coding agents ไม่ควรเชื่อมั่นในตัว AI อย่างสิ้นเชิงในการออกแบบแอปพลิเคชันที่ปลอดภัย ควรมีการให้คำแนะนำด้านความปลอดภัยที่ชัดเจนและการทดสอบอย่างละเอียดถี่ถ้วน

- ใช้และตรวจสอบ Security Headers, การป้องกัน CSRF และการจำกัดอัตราการล็อกอินในแอปพลิเคชัน แม้แต่แอปพลิเคชันที่พัฒนาโดยใช้ AI ก็ตาม

Source: https://thehackernews.com/2026/01/google-gemini-prompt-injection-flaw.html

Share this content: