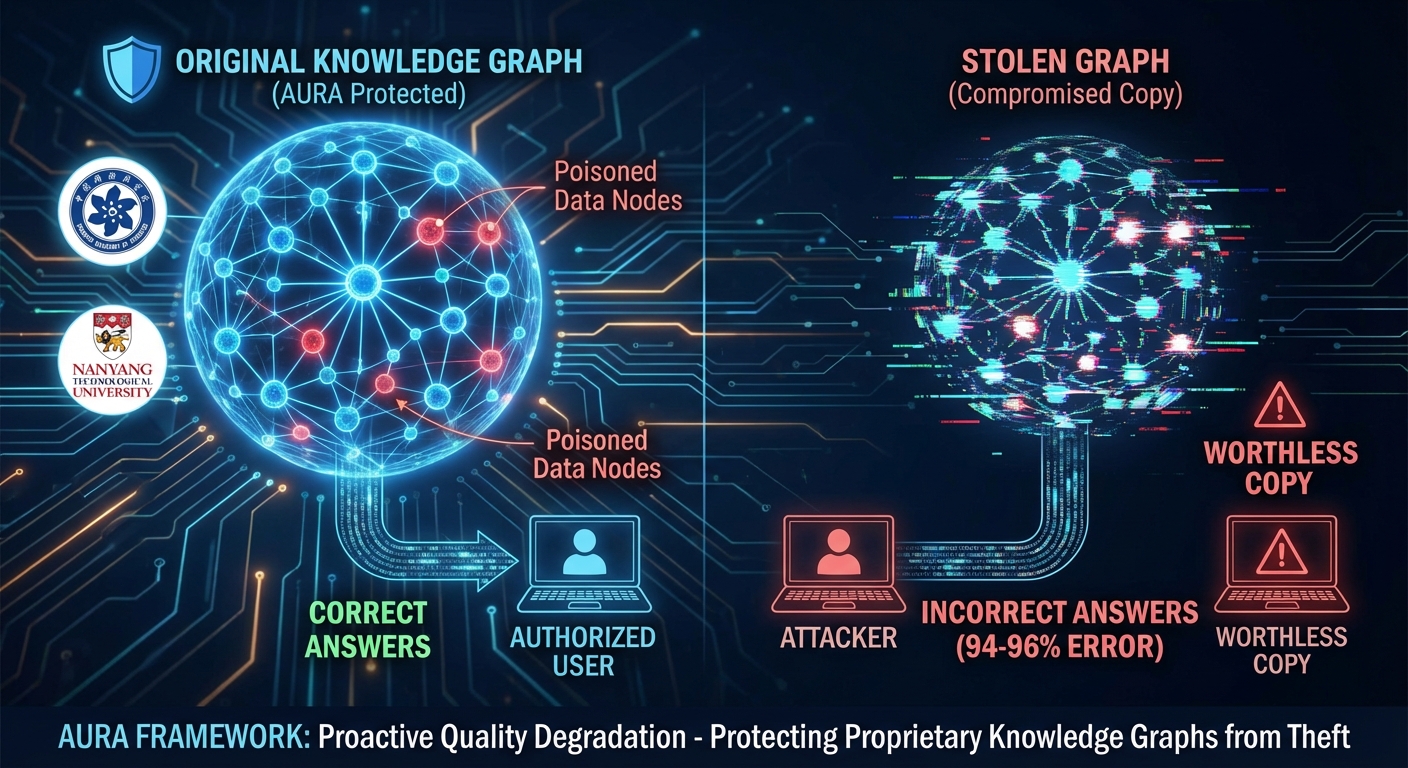

นักวิจัยจาก Chinese Academy of Sciences และ Nanyang Technological University ได้เปิดตัว AURA ซึ่งเป็นเฟรมเวิร์กใหม่เพื่อปกป้องกราฟความรู้ที่เป็นกรรมสิทธิ์ในระบบ GraphRAG จากการโจรกรรมและการแสวงหาประโยชน์ส่วนตัว งานวิจัยที่เผยแพร่บน arXiv ชี้ให้เห็นว่าการเจือปนกราฟความรู้ด้วยข้อมูลปลอมแต่สมจริงทำให้สำเนาที่ถูกขโมยไม่มีประโยชน์ต่อผู้โจมตี แต่ยังคงใช้งานได้เต็มที่สำหรับผู้ใช้ที่ได้รับอนุญาต AURA ใช้วิธีการ ‘การลดทอนคุณภาพเชิงรุก’ โดยการใส่ข้อมูล ‘เจือปน’ เทียมลงในโหนดสำคัญของกราฟความรู้ การทดสอบกับโมเดล AI ชั้นนำแสดงให้เห็นว่าสามารถพลิกคำตอบที่ถูกต้องให้ผิดได้ถึง 94-96% และป้องกันการตรวจจับข้อมูลปลอมได้อย่างมีประสิทธิภาพ แม้ว่าจะมีข้อจำกัดบางประการ แต่ AURA ก็เป็นเครื่องมือสำคัญในการปกป้องทรัพย์สินทางปัญญาในยุค AI

Severity: สูง

System Impact:

- Knowledge Graphs (KGs)

- GraphRAG Systems

- AI Models (เช่น GPT-4o, Gemini-2.5-flash, Qwen-2.5-7B, Llama2-7B)

- แอปพลิเคชันที่ขับเคลื่อนด้วยกราฟความรู้ (เช่น การค้นพบยาของ Pfizer, การผลิตของ Siemens)

Technical Attack Steps:

- ผู้โจมตีทำการโจรกรรมกราฟความรู้ที่เป็นกรรมสิทธิ์ (Proprietary Knowledge Graphs – KGs)

- ผู้โจมตีพยายามนำ KGs ที่ถูกขโมยไปใช้เพื่อจำลองความสามารถของ GraphRAG แบบส่วนตัว

- ระบบ AI ของผู้โจมตีที่ใช้ KGs ที่ถูกเจือปนจะสร้างผลลัพธ์ที่ไม่ถูกต้อง ทำให้ข้อมูลที่ขโมยมาไร้ประโยชน์

Recommendations:

Short Term:

- พิจารณาการนำเฟรมเวิร์กป้องกันข้อมูล เช่น AURA มาใช้เพื่อปกป้องกราฟความรู้ที่เป็นกรรมสิทธิ์

- ประเมินกลไกการป้องกันข้อมูลที่มีอยู่ในระบบ GraphRAG อย่างสม่ำเสมอ

Long Term:

- ลงทุนในกลยุทธ์การป้องกันข้อมูลขั้นสูงเพื่อรับมือกับการโจรกรรมข้อมูลในยุค AI

- พัฒนาหรือนำเทคนิค ‘การลดทอนคุณภาพเชิงรุก’ มาใช้เพื่อปกป้องทรัพย์สินทางปัญญาในระบบ AI

- ติดตามข่าวสารและพัฒนาการด้านความปลอดภัย AI โดยเฉพาะอย่างยิ่งในเรื่องการบิดเบือนข้อมูลและการปกป้องทรัพย์สินทางปัญญา

Source: https://cybersecuritynews.com/manipulate-stolen-data-corrupt-ai/

Share this content: